こんにちは、デザイナーのMHです。

ただいまLive2Dというソフトの学習をしています!

これまで簡単なモデリングを通してLive2Dの使い方を学んできました。前回はVtuberなどトラッキングソフトとの連動を想定したモデル作りを行いました。が、思った通りに動かず…

今回はトラッキングのリベンジを行いたいと思います。トラッキングソフトの使い方や設定など、より慎重に行なっていきます。

1、Live2Dでモデリングをする

さて、まずはいつも通りのモデリング作業です。

前回のキャラクターのモデルは退っ引きならないところまでモデリングしてしまった挙句上書き保存してしまったため、また新しいキャラクターを作成しました…。

反省を生かして、今回はモデリング中こまめにデータを分けながら保存しようと思います。

今回のメイン目的はトラッキング設定ですので、モデリングの様子は割愛します。

とはいえ今回は少しリッチな動きが可能なモデルになりました。仕様を簡単に紹介します。

まず、口が「あいうえお」の形に変形可能です。開け閉めの動きだけよりも、おしゃべりの様子がより自然に見えます。口が滑らかに変形する様子が可愛いです!

軸回転と物理演算設定も終えました。X(横の動き)だけでなく、Y(縦の動き)でも髪の毛が動くようになっています。

さらに、瞳のハイライトが目の開閉に合わせて揺れます!うん、可愛いです。

では、続いてこのモデルを使うために書き出していきましょう。

2、Live2Dで作ったモデルを書き出す

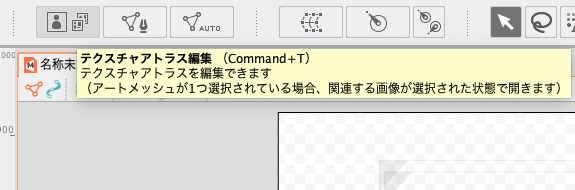

まずテクスチャアトラスを作成します。これを行わないと組み込み用モデルを作成できません。

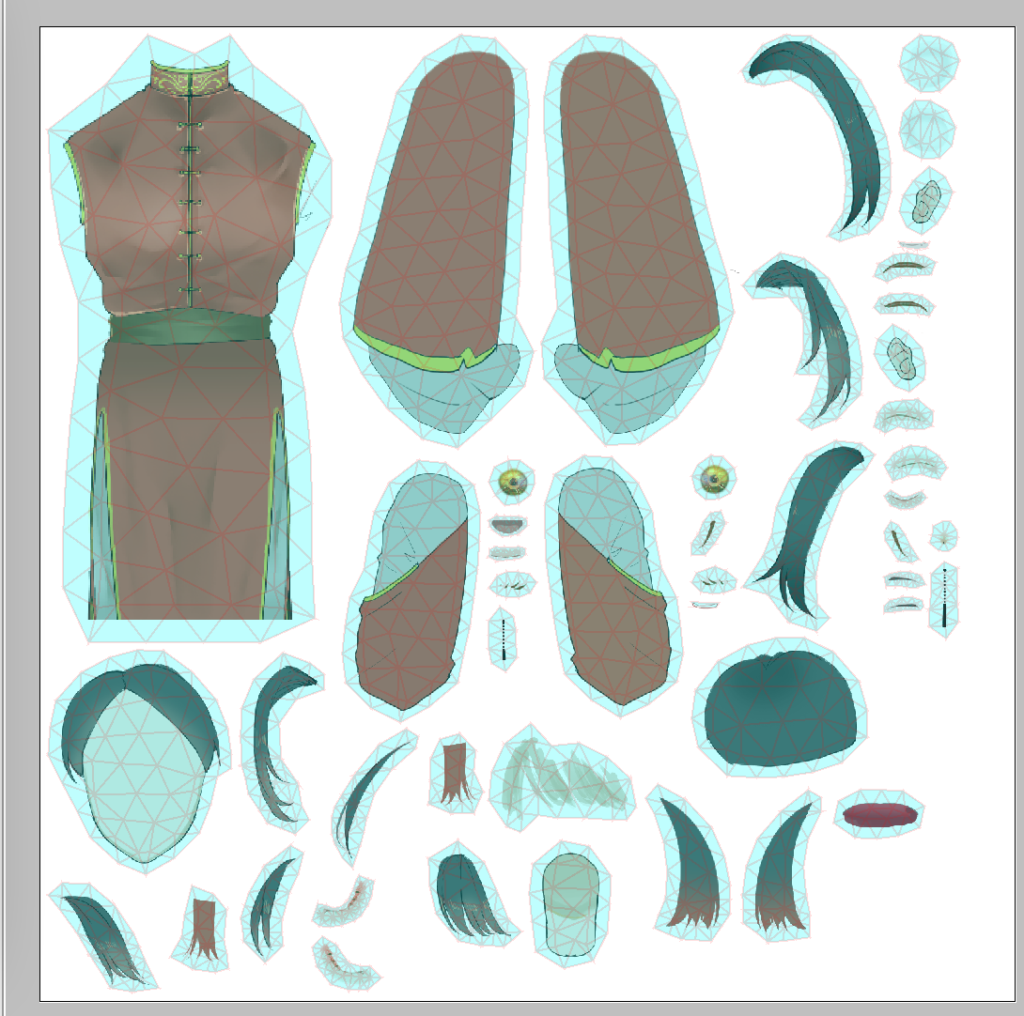

画面上部のタブからボタン選択し、テクスチャサイズを指定します。OKを押すと、以下のようなテクスチャアトラス編集画面が開きます。

モデルに使われている全てのパーツが配置されていることを確認したらOKを選択。これで書き出しの下準備が完了です。

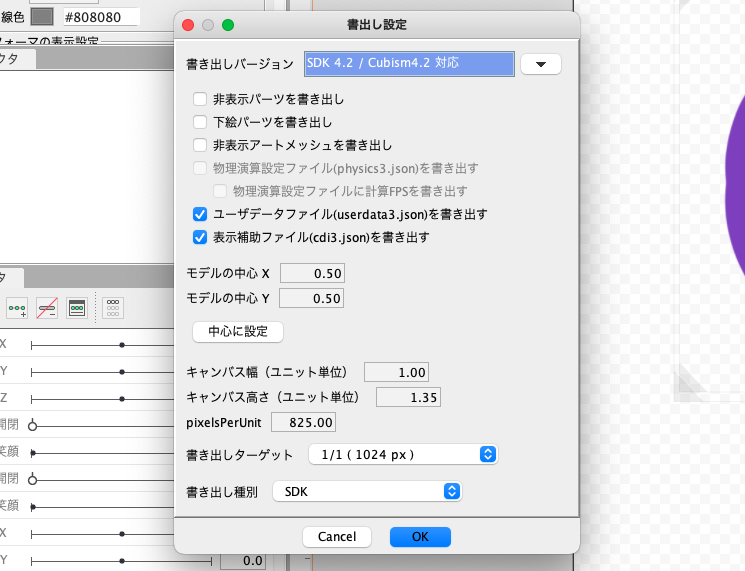

続いてタブから編集→「組み込み用ファイル書き出し」→今回は「moc3ファイルを書き出し」を選択します。

ちなみにmoc3はトラッキングソフトなどのプログラムで使用する Live2Dモデル用のデータです。

任意の書き出し設定を行いましょう。

また、物理演算設定を行なったモデルの場合は「物理演算ファイル(physics3.json)を書き出す」が有効になるので、トラッキングソフトで反映させたい場合はこちらにチェックを入れましょう。

これで書き出しは完了です。

2、オリジナルモデルをトラッキングソフトのVtube studioに読み込もう!

ではいよいよトラッキングソフトのvtube studioに書き出したモデルを読み込みます。

私はmacユーザーで、macに対応したトラッキングソフトでかつ無料の範囲でもとても優秀ということでこちらのソフトを使っていきます。

vtube studioはsteamで入手できますよ。

まずvtube studioを立ち上げると、いくつかのメニューアイコンが表示されます。

人のアイコンを選択することで、インポートされたモデルを選ぶことができます。初期状態はテスト用のモデルがいくつか入っているので、こちらを試しに使ってみることもできますよ。

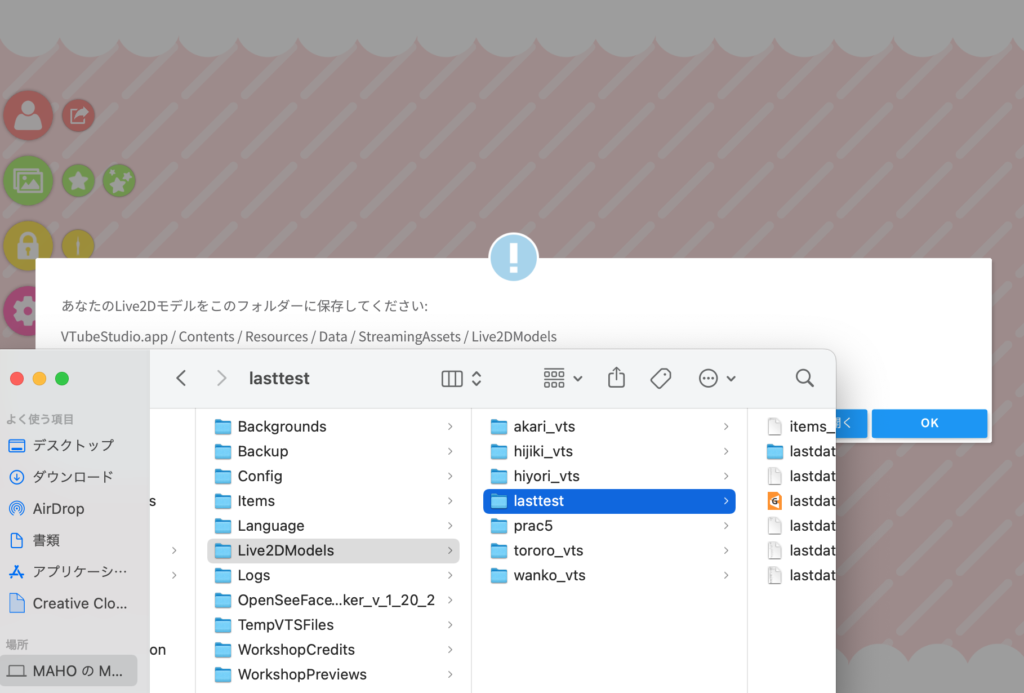

今回は先ほど書き出したオリジナルモデルを読み込んでいきたいので「自分のモデルをインポートする」を選択。

すると指定のフォルダーにモデルを保存するようにと表示されます。

「フォルダーを開く」をクリックすると指定のフォルダー(Live2Dmodels)が開きます。

ここにフォルダに書き出したモデルのデータをドラッグ&ドロップするだけでOK。

注意点として、先ほど書き出したデータは全て1つのファイル内に格納します。

mocデータ、テクスチャアトラスpng、必要に応じ物理演算ファイルやモデル選択時に表示されるアイコン画像なども入れましょう。

これをドラッグ&ドロップすると…

読み込み成功です。モデルが表示されました!

メニューアイコン→設定からカメラをオンにして、好きなように動いてみましょう。オリジナルのキャラクターが自分と同じ動きをしてくれます。これだけでなんだか嬉しいです!

3、モデルをトラッキングソフトのVtube studioに連動させて使ってみる!

さて、ようやくモデルを読み込めましたが、これだけではモデルは思うように動いてくれません。カメラをオンにして動いてみた方はあれ?と思ったかもしれませんが、なんだか勝手に動くパーツがあったり、目や口が思うように動かなかったり…

ので、ここからはトラッキングの詳細設定を行っていきます。少し根気のいる作業になりますが、これを丁寧に行うとモデルの動きが段違いです。

まずメニューアイコン→歯車マークから、画面上部に出てくるヒトに歯車がついたアイコンをクリック。

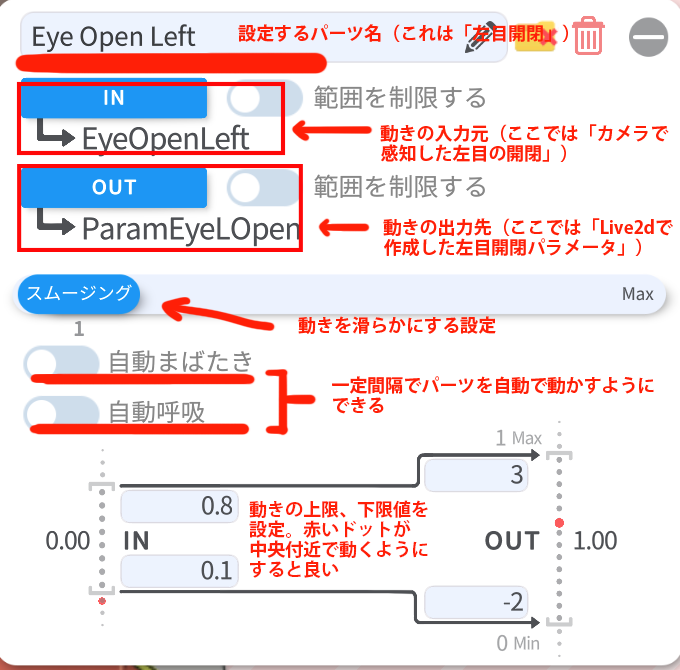

ここでは、live2dで作成した各パーツのモーションを、カメラでトラッキングした自分の顔のどのパーツの動き(or声)と連動させるか、またその感度や稼働範囲を設定できます。

そのため、パーツごとにパラメーターを設定する必要があります。「自動生成」である程度のパラメーターは作成されますが、足りないパーツ分は画面下部から新規パラメーターを作成しましょう。

パラメーターの項目の見方を簡単に解説します。

これらは全て任意の項目、数値にカスタムできます。

またINは基本的にカメラで読み取った体の動きですが、これを声にすることもできます。主な例としては

IN:カメラで感知した口の開閉と声⇆OUT:Live2dで作成した口の開閉パラメーター

です。声を出さなくても口を開ければモデルも口を開き、なおかつ発声に合わせて開閉もします。

こんな感じで自分の表情をチェックしながら、パラメーターの数値を一つ一つ変更していきましょう。

このトラッキング設定はモデルごとに保存されます。別のモデルをインポートした際、そちらに設定を引き継ぐことも可能です。

また、画像にも書いていますが、「自動まばたき」「自動呼吸」は一定間隔でパーツが勝手に動くようになります。呼吸モーションのパラメーターには最適な設定ですが、まゆげなどのパラメーターでONになっていると、勝手に上がり眉下がり眉になったりとかなり不自然です。

うっかりクリックしやすい位置にあるので、これの設定には注意してください。

さて、設定を終えました!動かしてみます。

概ね良いように見えますが、以下の点が気になりました。

- 右目の感度が悪い

- 口が閉じ切らないときがある

- 自分が正面を向いていても瞳が上を向きがち

それぞれIN,OUTの数値を変更し、設定し直しました。いかがでしょう。

どうしても右目が閉じ切らないのですが、ゆっくり長く瞬きをする分には閉じきるので、私本人がメガネをしているせいでカメラが読み取りにくいか、内臓カメラ自体の問題かもしれません。

また、上記はlive2dで作成するパラメータの状態が影響することもあるため、作成時には注意が必要です。

物理演算もしっかり反映されていますし、現状はいいのではないでしょうか。

…ということでこれで完成です!

4、Live2dとVtube studioで誰でもライバーデビューできる!

いかがでしたでしょうか?Live2dとVtube studio、どちらも細かな設定をしなければいけないのは避けられませんが、コツを覚えてしまえばモデルが可愛く動いてくれるのでその苦労も報われます。

なにより、そう難しいことは求められませんので、これは誰でもライバーになれちゃうわけですね。巷に可愛い、かっこいいVtuberさんがたくさんいるのにも納得です。

まだまだ覚えて実装すればよりリアリティのあるモデルにできそうですし、平面イラストを動かすという仕様だからこそできる表現方法もたくさんありそうです。

今後は覚えておきたい便利なテクニックや、+αの技術を学び次第記録していこうと思います。モデリングスキルアップの道、今後もお付き合い頂ければ幸いです。

>>Live2dでのモデリング受注を開始しました!まずは相談だけでもお気軽にどうぞ!

↓こちらをクリック!↓